Google durcit le ton contre les fermes à contenus plagiés. Ces plateformes, qui abondent en articles copiés-collés pour attirer le trafic et générer des revenus publicitaires, constituent un véritable fléau pour la qualité de l’information en ligne. En réponse, Google a mis à jour son algorithme pour pénaliser sévèrement ces pratiques.

Les nouvelles mesures visent à valoriser les contenus originaux et de qualité, tout en réduisant la visibilité des sites qui se contentent de dupliquer des articles existants. Les créateurs de contenu authentique espèrent que cette action permettra de restaurer la crédibilité et l’intégrité de l’information sur internet.

Historique des actions de Google contre les fermes à contenus plagiés

Google a initié la lutte contre les fermes à contenus plagiés avec le lancement de l’algorithme Google Panda. Déployé officiellement le 24 février 2011, Panda a d’abord été testé aux États-Unis avant d’impacter les résultats de recherche en Europe et aux États-Unis à partir du 11 août 2011. Cet algorithme vise spécifiquement les sites qui se contentent de dupliquer des articles existants, les pénalisant sévèrement dans les résultats de recherche.

Google Panda a été développé par Google pour cibler les fermes de contenus. L’objectif est clair : expurger les résultats des pages au contenu dupliqué, insuffisant ou de piètre qualité. Aujourd’hui, Panda fait partie intégrante de l’algorithme de Google. Les mises à jour et sanctions se font désormais en temps réel, impactant jusqu’à 12 % des résultats de recherche.

Depuis son intégration en mars 2013, Panda évalue la qualité du contenu en continu, sanctionnant sévèrement les sites ne respectant pas les standards de qualité. Cette intégration se traduit par des pénalités qui peuvent aller jusqu’à la déclassification ou le blacklisting des sites concernés. Les sanctions sont devenues plus graduelles et proportionnées, mais restent redoutées par les administrateurs web.

La stratégie de Google repose sur la valorisation des contenus authentiques et de haute qualité. En ciblant les fermes à contenus plagiés, Google cherche à améliorer l’expérience utilisateur et à garantir des résultats de recherche pertinents et fiables. Cette approche s’inscrit dans une politique plus large de lutte contre le duplicate content et le content spinning, deux fléaux majeurs du web actuel.

Les algorithmes de Google et leur rôle dans la détection du contenu dupliqué

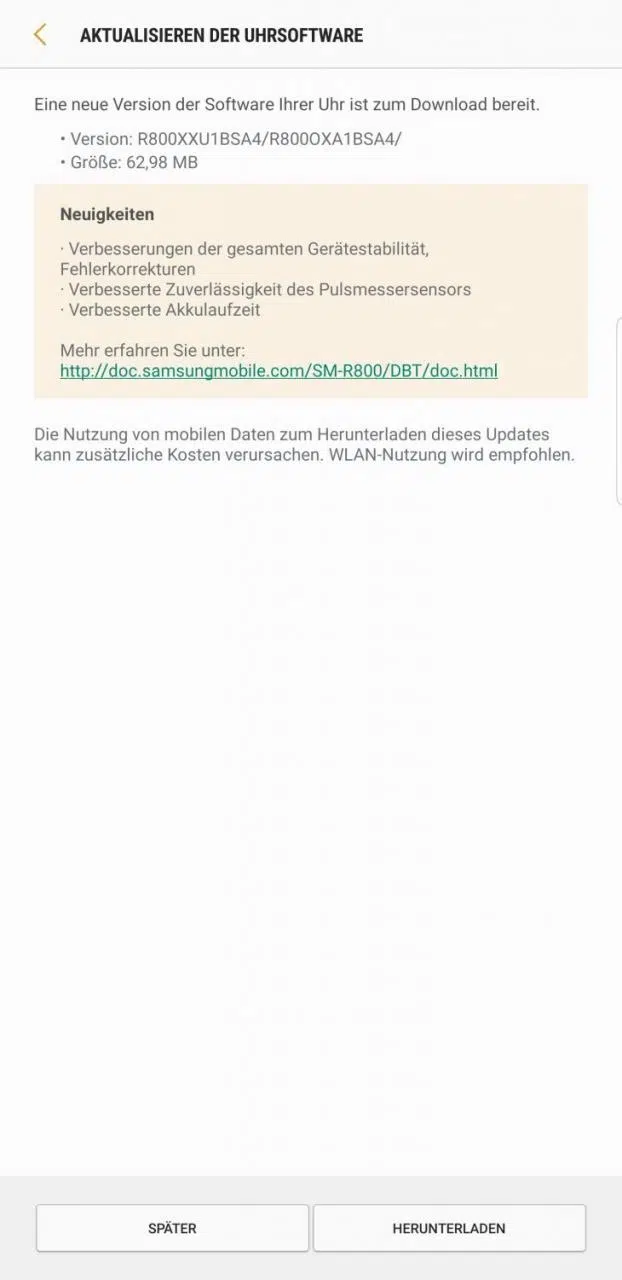

Google utilise plusieurs algorithmes pour traquer le duplicate content et le content spinning. Parmi eux, Google Panda se distingue comme un filtre majeur. Lancé en février 2011, Panda a subi diverses mises à jour pour affiner son efficacité.

- Panda 1.0 : première version déployée en février 2011

- Panda 2.0 : mise à jour en avril 2011, impactant les résultats mondiaux

- Panda 2.4 : extension aux langues autres que l’anglais en août 2011

- Panda 3.0 : série de petites mises à jour en octobre 2011

- Panda Everflux : intégration continue et en temps réel à partir de mars 2013

Le rôle de ces algorithmes est d’expurger des résultats de recherche les pages au contenu dupliqué ou de mauvaise qualité. Depuis son intégration en temps réel, Panda évalue constamment la qualité des sites. Les mises à jour se font de manière continue, ce qui permet à Google de pénaliser plus rapidement les sites contrevenants.

Ces sanctions, parfois appelées pénalités Google, peuvent être sévères. Les sites visés risquent déclassification ou blacklisting, affectant leur visibilité dans les SERPs (pages de résultats des moteurs de recherche). Les propriétaires de sites doivent ainsi s’assurer de respecter les directives de Google en matière de SEO pour éviter ces pénalités.

Conséquences pour les sites utilisant des fermes à contenus plagiés

Google Panda, en ciblant les fermes de contenus, a profondément modifié le paysage du web. Les sites qui s’appuient sur des contenus plagiés risquent des sanctions sévères. Parmi les pénalités les plus fréquentes, on note le déclassement et le blacklisting des pages concernées.

Effectivement, les sanctions de Google Panda sont aujourd’hui plus graduelles et proportionnées. Elles restent dissuasives. Les sites déclassés voient leur trafic chuter drastiquement, ce qui impacte directement leurs revenus et leur visibilité en ligne. Les propriétaires de sites doivent veiller à la qualité de leur contenu pour éviter ces désagréments.

Google Panda ne se contente pas de pénaliser. Il évalue aussi en continu la qualité du contenu publié. Les sites ne respectant pas les directives de Google en matière de SEO se trouvent rapidement sanctionnés. Cette surveillance constante pousse les webmasters à adopter de meilleures pratiques, garantissant ainsi une expérience utilisateur optimale.

Pour éviter les pénalités, suivez quelques recommandations simples :

- Publiez du contenu original et de qualité

- Utilisez des outils comme Google Search Console pour surveiller les performances de votre site

- Évitez les techniques de Black Hat SEO telles que les fermes de liens

Ces mesures permettront de maintenir ou améliorer votre classement dans les SERPs et d’assurer une présence en ligne durable.

Meilleures pratiques pour éviter les pénalités liées au contenu dupliqué

Pour échapper à la vigilance de Google Panda, quelques pratiques simples mais efficaces existent. D’abord, misez sur l’originalité et la qualité de vos contenus. Évitez à tout prix le duplicate content et le content spinning. Ces techniques, autrefois prisées, sont désormais synonymes de sanctions.

Utilisez des outils comme Google Search Console. Cet outil développé par Google permet de surveiller les performances de votre site, d’identifier les problèmes de contenu et de recevoir des notifications concernant les pénalités potentielles. Il faut s’en servir pour rester en conformité avec les directives de Google.

Recommandations pratiques

- Créez du contenu original et engageant

- Évitez les pratiques de Black Hat SEO, telles que les fermes de liens

- Surveillez régulièrement vos performances via Google Search Console

Considérez l’intégration de données structurées dans vos pages web. Ces balises aident les moteurs de recherche à comprendre le contenu de vos pages, améliorant ainsi leur indexation et limitant les risques de pénalités. Un fichier robots.txt bien configuré peut aussi prévenir l’indexation des pages de faible qualité.

Ces pratiques, bien que simples, sont essentielles pour maintenir et améliorer votre classement dans les SERPs. Une stratégie de contenu solide et une surveillance continue garantiront une présence en ligne durable.