78 % des entreprises admettent avoir déjà subi des pertes financières ou opérationnelles à cause de la mauvaise qualité de leurs données. Ce chiffre, loin d’être anodin, dit tout : la fiabilité de l’information n’est ni un détail technique ni un caprice de DSI, mais un enjeu qui peut désarçonner une organisation entière.

Pourquoi la qualité des données se dégrade dans les organisations

La qualité des données occupe une place centrale dans les stratégies numériques. Pourtant, rares sont les organisations capables de garantir un niveau constant, sans faille, sur l’ensemble de leurs ensembles de données. Premier constat : la multiplication des sources et l’hétérogénéité des systèmes complexifient la gestion de la qualité. Un même fichier circule entre différents départements, chacun appliquant ses propres règles, ses formats et ses priorités. Résultat, les problèmes de qualité des données s’invitent dans la chaîne de valeur, parfois sans être immédiatement détectés.

Les causes de ces dérives se nichent dans des détails : saisies manuelles, processus non harmonisés, absence de référentiels partagés. Selon plusieurs audits menés en entreprise, la cause la plus courante réside dans le manque de clarté sur la responsabilité liée à chaque donnée. Le flou sur “qui fait quoi” ouvre la porte à des erreurs répétitives, difficiles à corriger en aval.

On observe généralement plusieurs types d’incidents qui empoisonnent la fiabilité des données :

- données incomplètes ou obsolètes

- incohérences entre systèmes

- doublons générés lors de la migration d’ensembles

- variations de format non anticipées lors de l’intégration de nouvelles applications

La sophistication des outils ne suffit pas à écarter ces risques. Sans une gouvernance structurée, sans garde-fous adéquats, les défaillances se multiplient et s’ancrent dans la durée.

Quels sont les facteurs les plus fréquents à l’origine des erreurs de données ?

La défaillance la plus fréquemment rencontrée ne se cache pas dans la technologie. Elle naît bien plus souvent de processus confus ou d’une répartition floue des responsabilités. Les spécialistes du secteur tirent la sonnette d’alarme : l’organisation du traitement des données, trop fragmentée, brouille la traçabilité et empêche de remonter facilement à une cause racine.

Dans la majorité des entreprises, l’insuffisance des contrôles en amont laisse passer d’innombrables imprécisions. Une saisie manuelle oubliée, une règle métier mal définie, et c’est tout un référentiel qui peut chanceler. Les audits mettent souvent en avant l’absence de formats standardisés et le manque de documentation, qui entretiennent ce cercle vicieux.

L’humain joue un rôle déterminant. Une formation superficielle ou des échanges déficients entre services accentuent les erreurs. Face à des outils disparates, les équipes improvisent des solutions temporaires qui, au fil du temps, créent de nouvelles complications.

Voici les catégories majeures de causes à surveiller de près :

- Processus métiers non alignés ou trop complexes

- Absence de responsabilité clairement attribuée à chaque étape du cycle de vie de la donnée

- Défaut de validation systématique lors des mises à jour ou intégrations

Pour remonter à la source des problèmes, il faut s’appuyer sur des analyses détaillées, des contrôles réguliers et une cartographie précise des flux. Seule une démarche structurée permet d’endiguer durablement les erreurs et d’installer une véritable culture de la qualité.

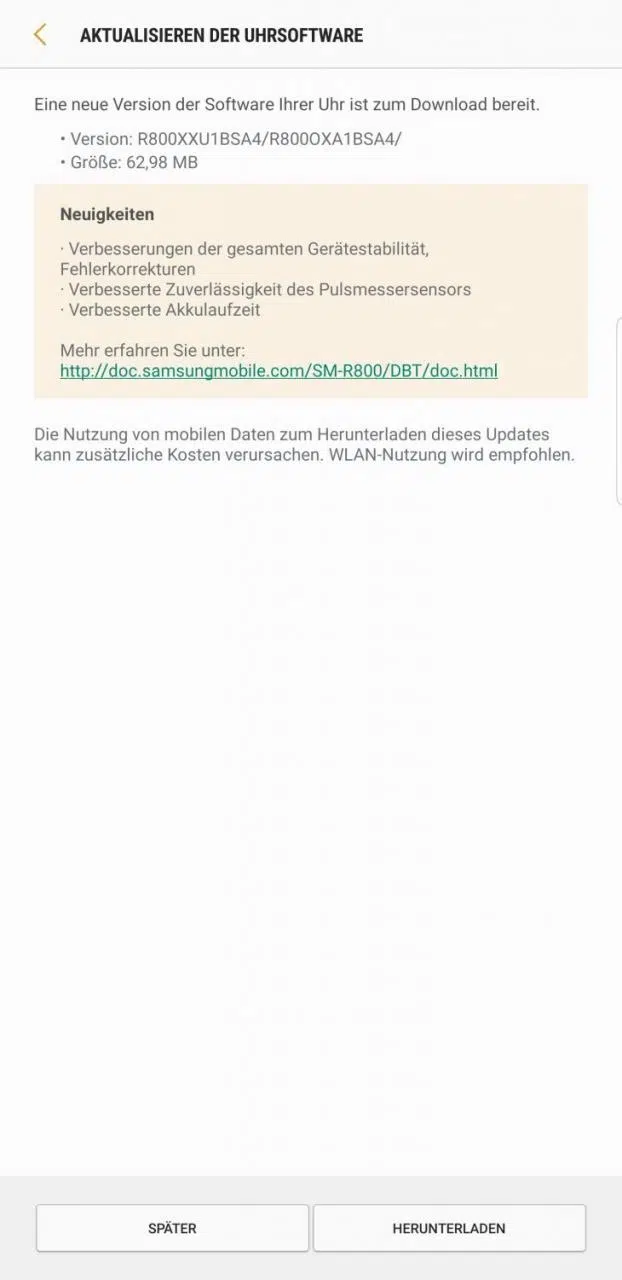

Analyse des causes profondes : comment le diagramme d’Ishikawa et la méthode des 5 Pourquoi apportent des réponses concrètes

Face à des anomalies récurrentes, les équipes cherchent inévitablement à comprendre l’origine profonde de chaque incident. Deux approches font la différence : le diagramme d’Ishikawa (ou diagramme arête de poisson) et la méthode des 5 Pourquoi, popularisée par Sakichi Toyoda.

Le diagramme d’Ishikawa apporte une structure visuelle et logique à l’analyse. En passant en revue les grandes familles de causes (méthodes, machines, main d’œuvre, milieu, matières, management), il révèle les interactions et découpe les enchaînements de facteurs qui aboutissent au problème. Cette vue d’ensemble aide les équipes à repérer les points de blocage ou les zones floues qui réclament une attention spécifique.

Quant à la méthode des 5 Pourquoi, elle s’appuie sur un questionnement en cascade. Devant une anomalie, on interroge cinq fois de suite le “pourquoi” du dysfonctionnement. Cette progression, simple mais redoutablement efficace, évite de s’arrêter à la première justification, souvent superficielle. Elle permet d’aller au fond des choses, jusqu’à la racine, même quand celle-ci se révèle plus systémique que ponctuelle.

S’appuyer sur ces deux méthodes, c’est s’offrir une analyse robuste et collective. L’alliance du visuel et du questionnement méthodique éclaire les choix, accélère la résolution et installe une dynamique d’amélioration continue dans l’organisation.

Exemples pratiques pour appliquer ces méthodes et améliorer durablement la qualité des données

Identifier la cause racine d’un défaut dans un ensemble de données n’a rien d’anecdotique, à condition d’en faire le point de départ d’actions concrètes et durables. Un exemple frappant : dans une grande banque, la multiplication des erreurs sur les dates de naissance a conduit à l’utilisation du diagramme d’Ishikawa. Les équipes se sont penchées sur les processus de saisie, les interfaces utilisateurs, la formation des opérateurs, mais aussi sur les formats imposés par le système d’information. Cette démarche a permis de cerner le vrai blocage : l’absence de contrôle automatique lors de la saisie. La mise en œuvre d’une validation logicielle a aussitôt réduit le taux d’erreur.

Les bénéfices d’une telle approche dépassent la simple correction. Il s’agit d’inscrire la qualité des données dans la durée, en adoptant des routines adaptées. Un tableau de bord de KPI (indicateurs clés) permet par exemple de suivre semaine après semaine la conformité des jeux de données et le volume d’incidents détectés puis corrigés.

Voici plusieurs leviers concrets à activer pour ancrer cette dynamique :

- Mettre en place des formations ciblées pour les équipes métiers : comprendre la gestion des données et ses risques, c’est éviter bien des écueils.

- Intégrer l’analyse des causes racines à la gouvernance des données, avec un retour d’expérience systématique après chaque incident notable.

- S’équiper d’outils simples et partagés : fichier de suivi des anomalies, workflow de validation, reporting régulier.

En combinant ces actions, la gestion de la qualité prend une autre dimension. Elle ne dépend plus de l’improvisation mais d’une démarche structurée, pilotée, et portée par la culture de l’organisation.

À force de vigilance et d’exigence, la donnée cesse d’être un terrain miné pour devenir un levier fiable, sur lequel s’appuyer sans craindre la prochaine défaillance.