L’essor des bots conversationnels bouleverse le paysage du numérique, offrant de nouvelles perspectives, mais soulevant aussi des préoccupations majeures. Les enjeux éthiques et sécuritaires qui en découlent questionnent la confiance, la responsabilité et la protection des utilisateurs. Découvrez dans les prochains paragraphes comment ces défis influencent le développement et l’utilisation de ces intelligences artificielles, et quelles solutions sont envisagées pour un futur plus serein.

Sensibilisation aux biais algorithmiques

Les biais présents dans les algorithmes des bots conversationnels émergent principalement lors de la phase de machine learning, où l’algorithme apprend à partir de données collectées sur Internet ou auprès d’utilisateurs réels. Ces jeux de données, souvent issus d’environnements peu diversifiés, introduisent facilement des biais historiques ou culturels qui risquent de se perpétuer dans les réponses générées par les bots. Cela peut conduire à des formes subtiles ou manifestes de discrimination, par exemple en négligeant certaines minorités ou en reproduisant des stéréotypes. Les conséquences pour les utilisateurs sont multiples : un manque de diversité dans les réponses, une limitation de l’équité dans l’accès à l’information et, parfois, des décisions influencées négativement par l’algorithme lui-même.

Il est essentiel d’adopter diverses stratégies pour limiter ces biais et garantir une expérience utilisateur plus équitable. La diversification des sources de données, la supervision humaine régulière des réponses générées et l’intégration de protocoles éthiques dans le développement des algorithmes sont des pistes incontournables. L’implication d’experts en intelligence artificielle et en éthique permet de mieux comprendre l’impact sociétal de la technologie et d’anticiper les dérives possibles. Pour les utilisateurs souhaitant expérimenter de manière responsable les capacités des bots conversationnels, il peut être judicieux de tester des outils comme ChatGPT gratuitement, afin d’observer comment la diversité et l’équité sont prises en compte dans les interactions.

Protection des données personnelles

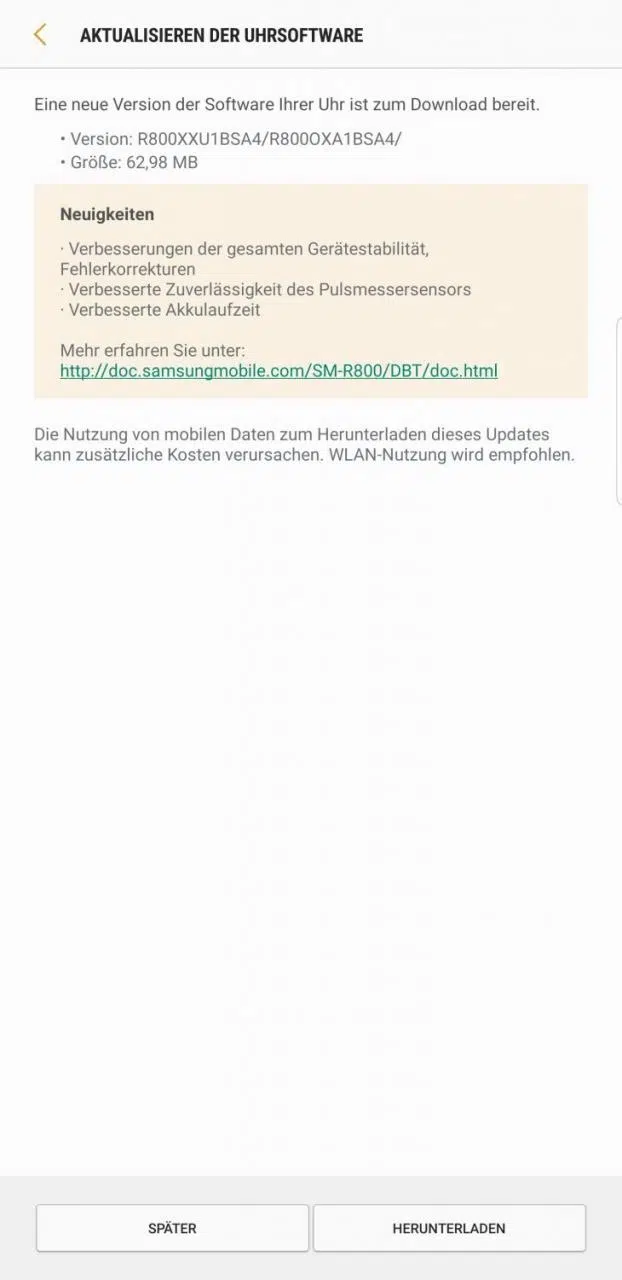

La gestion des informations sensibles par les bots conversationnels soulève de nombreux points liés à la sécurité et à la confidentialité. Lorsqu’un utilisateur échange avec un bot, il partage souvent des données personnelles, qui peuvent inclure des éléments très privés comme des adresses, des coordonnées bancaires ou des informations médicales. Ces échanges créent un risque réel de fuites, notamment en cas de vulnérabilité dans l’infrastructure technique ou d’erreur dans la configuration du cryptage des communications. Pour réduire ces risques, les plateformes doivent adopter des mesures strictes, telles que l’utilisation systématique du cryptage pour protéger les données en transit et au repos.

Face à ces enjeux, le respect du RGPD devient incontournable pour toute entreprise opérant en Europe ou traitant avec des citoyens européens. Cette réglementation encadre la collecte, l’utilisation et la conservation des données personnelles, imposant entre autres l’obtention du consentement explicite de l’utilisateur avant tout traitement. Afin de garantir la confidentialité des échanges, il est recommandé de minimiser la quantité d’informations collectées, d’offrir la possibilité à l’utilisateur de contrôler ses données et de mettre en œuvre des audits réguliers des systèmes de sécurité. Adopter une démarche proactive en cybersécurité, en intégrant des mécanismes de cryptage robustes et en sensibilisant les équipes à la gestion du consentement, permet aux organisations de mieux protéger la vie privée des utilisateurs face aux défis posés par l’essor des bots conversationnels.

Détection et gestion des conversations malveillantes

La sécurité dans l’utilisation des bots conversationnels repose en grande partie sur la capacité à détecter rapidement les usages malveillants, tels que le harcèlement, la manipulation ou la propagation de contenu illicite. Grâce à l’analyse sémantique, il est désormais possible d’identifier, en temps réel, des schémas linguistiques suspects ou des propos offensants. Les systèmes de filtrage automatique jouent un rôle primordial : ils passent au crible chaque message échangé afin de repérer les tentatives de harcèlement ou les manœuvres de désinformation. Ce processus est optimisé par l’apprentissage automatique, qui affine continuellement la reconnaissance des contenus problématiques, tout en limitant les faux positifs susceptibles de brider la liberté d’expression.

Parallèlement aux dispositifs techniques, la modération humaine reste un pilier de la lutte contre les abus, surtout dans les situations ambiguës que les algorithmes peinent à interpréter. Les modérateurs interviennent en complément des outils automatiques, pour assurer une surveillance plus nuancée et adaptée au contexte. La combinaison de l’analyse sémantique avancée et de procédures de modération hybrides favorise la création d’espaces conversationnels plus sûrs. Ces dispositifs contribuent à protéger les utilisateurs contre les risques liés au harcèlement ou à la diffusion de contenu illicite, tout en renforçant la confiance dans l’usage des bots conversationnels au sein des communautés en ligne.

Transparence et explicabilité des algorithmes

La transparence des bots conversationnels constitue un défi central à l’ère des intelligences artificielles, où la boîte noire algorithmique rend difficile la compréhension du fonctionnement interne des systèmes. Les utilisateurs doivent pouvoir saisir comment s’opèrent les décisions automatisées, surtout lorsque ces décisions influencent des domaines sensibles comme la santé, la finance ou l’éducation. L’explicabilité des algorithmes ne se limite pas à une simple ouverture du code source, mais implique une capacité à rendre les processus décisionnels clairs et accessibles à tous, indépendamment de leur expertise technique. Cette démarche favorise une meilleure confiance envers les technologies, puisque les individus peuvent alors vérifier si les choix opérés respectent l’équité et l’absence de biais. Éclaircir les mécanismes de raisonnement des intelligences artificielles permet également d’impliquer les parties prenantes dans une réflexion collective sur les valeurs intégrées à ces systèmes.

Un chercheur en éthique des technologies de l’information est particulièrement habilité à explorer ces questions, car il possède une vision globale des enjeux liés à la transparence et à l’explicabilité. Il met en lumière les bénéfices que la compréhension des décisions automatisées procure, tant pour la société que pour les développeurs de ces outils. Renforcer la confiance passe par la création de protocoles clairs, des audits réguliers et une communication adaptée sur les limites des bots conversationnels. Cette approche proactive permet de prévenir les abus tout en offrant des garanties sur la responsabilité et la fiabilité des systèmes automatisés, contribuant ainsi à une adoption sereine et éclairée des nouvelles technologies.

Responsabilité en cas de dérive

La responsabilité autour des bots conversationnels suscite de nombreux débats, car elle implique à la fois la législation, l’éthique et la supervision. Lorsqu’un bot adopte un comportement problématique – diffusion de propos discriminatoires, incitation à des actes dangereux ou collecte abusive de données – il s’avère essentiel de déterminer qui doit répondre de ces dérives. Les développeurs portent une part non négligeable de cette responsabilité, car ils conçoivent l’architecture, choisissent les jeux de données d’entraînement et définissent les garde-fous algorithmiques. Cela inclut la mise en place d’un audit de conformité régulier, permettant de vérifier que le bot respecte les normes éthiques et juridiques en vigueur, tout en anticipant les risques de dérive.

La législation nationale et européenne impose des obligations précises aux concepteurs, notamment en matière de protection des données personnelles et de respect de la vie privée. Les développeurs doivent également s’assurer que les systèmes de supervision soient capables de détecter rapidement toute utilisation malveillante ou tout comportement inattendu du bot. L’audit de conformité constitue un outil indispensable pour s’assurer que le bot respecte ces contraintes, en évaluant son comportement réel face à une variété de scénarios. En cas de litige, la traçabilité des choix de conception et des mesures de supervision peut s’avérer déterminante pour établir la responsabilité des différentes parties prenantes.

La réflexion autour de la responsabilité doit aussi intégrer la dimension morale, car les conséquences des interactions avec un bot conversationnel ne se limitent pas toujours au cadre légal. Il appartient aux développeurs et à l’ensemble de la chaîne de supervision d’anticiper les abus éventuels en dotant le système de mécanismes d’alerte et de contrôle. Une sensibilisation régulière des équipes techniques à l’éthique, l’organisation d’audits de conformité ainsi qu’une collaboration avec des juristes experts en droit du numérique permettent de renforcer la robustesse des dispositifs. Cette vigilance collective s’avère indispensable pour garantir la confiance des utilisateurs et prévenir efficacement les risques associés à ces technologies émergentes.